【クローラビリティ】に関するSEOアンケート調査を325人に実施!調査結果を大公開

「クローラビリティ」に関する9個のSEOアンケート調査を、ディーボのSEOラボX公式アカウントで行いました。

このX公式アカウントで2025年10月14日~24日の期間に行った総勢325人の「クローラビリティ」に関するアンケート調査結果、調査結果から言えることを中心に、初心者にもわかりやすくポイントをまとめて解説したいと思います。

- 「クローラビリティ」に関するSEOアンケート調査結果

- 現在、ウェブサイトのクローラビリティを向上させるために最も注力している施策は何ですか?

- クローラビリティにおいて、robots.txtのアクセス制御の活用状況は?

- クローラビリティにおいて、XMLサイトマップの現在の運用状況は?

- クローラビリティにおいて、Googleサーチコンソールのクロール統計・エラー報告の確認頻度は?

- クローラビリティにおいて、クロールバジェットを意識した対策は?

- 新しい重要なコンテンツを公開した際、Googleサーチコンソールでクロールをリクエストしていますか?

- クローラビリティにおいて、サイト内の最も深いページ(トップページからクリックで辿る階層)は、平均してどの程度の深さになっていますか?

- クローラビリティの課題として、あなたのサイトで最も深刻だと考えている技術的要因は?

- リンク切れ(404エラー)が発生した場合、クローラビリティの観点からどのように対応していますか?

- 「クローラビリティ」に関するSEOアンケート調査結果から言えること

- 「クローラビリティ」に関するSEOアンケート調査概要

「クローラビリティ」に関するSEOアンケート調査結果

「クローラビリティ」に関するSEOアンケート調査を9個行ったので、それぞれの調査結果を紹介します。

- 現在、ウェブサイトのクローラビリティを向上させるために最も注力している施策は何ですか?

- クローラビリティにおいて、robots.txtのアクセス制御の活用状況は?

- クローラビリティにおいて、XMLサイトマップの現在の運用状況は?

- クローラビリティにおいて、Googleサーチコンソールのクロール統計・エラー報告の確認頻度は?

- クローラビリティにおいて、クロールバジェットを意識した対策は? 新しい重要なコンテンツを公開した際、Googleサーチコンソールでクロールをリクエストしていますか?

- クローラビリティにおいて、サイト内の最も深いページ(トップページからクリックで辿る階層)は、平均してどの程度の深さになっていますか?

- クローラビリティの課題として、あなたのサイトで最も深刻だと考えている技術的要因は?

- リンク切れ(404エラー)が発生した場合、クローラビリティの観点からどのように対応していますか?

現在、ウェブサイトのクローラビリティを向上させるために最も注力している施策は何ですか?

「現在、ウェブサイトのクローラビリティを向上させるために最も注力している施策は何ですか?」のアンケートに対して54人が回答した結果です。

【SEOアンケート調査】現在、ウェブサイトのクローラビリティを向上させるために最も注力している施策は何ですか?#クローラビリティ #SEO #ディーボのSEOラボ

— ディーボのSEOラボ@SEO対策 (@seolabo85) October 14, 2025

この調査結果から、回答者の48.1%が「内部リンク最適化(パンくずリスト、階層構造改善等)」に最も注力していると回答し、最多となりました。

これは、Googleのクローラーがサイトの構造を理解しやすくし、重要なページへ効率的に到達させるための構造的な施策が重視されていることを示しています。

次に多かったのが「低品質または重複コンテンツの整理・削除」(19.5%)で、サイト全体の品質を維持し、クロールバジェットの浪費を防ぐためのコンテンツ的な施策にも関心が集まっています。

一方、「ページの読み込み速度の改善」(14.8%)や「技術的設定整備」(5.6%)は注力度が低い結果となりました。

このことから、多くのサイト運営者は、クローラビリティの核心として、サイト内部のナビゲーション(内部リンク)の整備とコンテンツの質の管理を最重要視していると言えます。

特に内部リンクの最適化は、クローラビリティだけでなくユーザーエクスペリエンスやE-E-A-T評価にも影響するため、総合的なSEOの基盤として認識されていることが伺えます。

クローラビリティにおいて、robots.txtのアクセス制御の活用状況は?

「クローラビリティにおいて、robots.txtのアクセス制御の活用状況は?」のアンケートに対して29人が回答した結果です。

【SEOアンケート調査】クローラビリティにおいて、robots.txtのアクセス制御の活用状況は?#クローラビリティ #SEO #ディーボのSEOラボ

— ディーボのSEOラボ@SEO対策 (@seolabo85) October 15, 2025

この調査結果から、回答者の58.6%が「基本的な設置のみ行っている」と回答し、過半数を占めました。

これは、robots.txtがSEOの基本的な技術的要件として認識され、多くのウェブサイトで最低限の設置は実施されていることを示しています。

一方、驚くべきことに24.1%が「そもそもrobots.txtは設置していない」と回答しており、基本的なクローラー制御の仕組みが未導入のサイトが約4分の1存在するという現状が明らかになりました。

また、「必須以外は全てブロックしている」(10.3%)や「定期的に確認し誤設定を修正している」(6.9%)といった積極的・継続的な活用をしている層は少数派です。

このことから、robots.txtは基本的な存在としては認識されつつも、積極的なクロール最適化や誤設定の定期的なチェックといった高度な運用が普及していないことがわかります。

特に未設置のサイトにとっては、クロールバジェットの浪費や機密情報の露出といったリスクが存在するため、最低限の設置と適切な運用が強く推奨されます。

クローラビリティにおいて、XMLサイトマップの現在の運用状況は?

「クローラビリティにおいて、XMLサイトマップの現在の運用状況は?」のアンケートに対して37人が回答した結果です。

【SEOアンケート調査】クローラビリティにおいて、XMLサイトマップの現在の運用状況は?#クローラビリティ #SEO #ディーボのSEOラボ

— ディーボのSEOラボ@SEO対策 (@seolabo85) October 16, 2025

この調査結果から、回答者の73%が「ページ更新時に自動で生成・更新」していると回答し、圧倒的多数を占めました。

これは、XMLサイトマップがSEOの必須技術要素として広く認識され、その運用が自動化によって効率的かつ継続的に行われていることを示しています。

一方、16.2%が「存在するが長期間更新していない」と回答しており、サイトマップを最新の状態に保つという点において課題を抱えている層が一定数いることがわかります。

また、「手動で作成・更新」(5.4%)や「作成・送信していない」(5.4%)という回答もあり、小規模サイトや技術リソースの少ないサイトでは、依然として適切な運用が行われていない可能性があります。

このことから、多くのサイト運営者はXMLサイトマップの重要性を理解し、自動生成という理想的な形で運用しています。

ですが、約5分の1のサイトでは情報の鮮度が保証されていない状態であり、クローラビリティを最大限に引き出すためには、自動化と最新情報の維持が極めて重要であると言えます。

クローラビリティにおいて、Googleサーチコンソールのクロール統計・エラー報告の確認頻度は?

「クローラビリティにおいて、Googleサーチコンソールのクロール統計・エラー報告の確認頻度は?」のアンケートに対して24人が回答した結果です。

【SEOアンケート調査】クローラビリティにおいて、Googleサーチコンソールのクロール統計・エラー報告の確認頻度は?#クローラビリティ #SEO #ディーボのSEOラボ

— ディーボのSEOラボ@SEO対策 (@seolabo85) October 17, 2025

この調査結果から、「毎日または公開直後に確認」が45.8%で最も多く、次いで「週に1回程度」が29.2%となりました。

これは、回答者の約75%が毎週以上の高頻度でGSCを確認しており、クロール関連の問題を早期に発見・対処する意識が非常に高いことを示しています。

また、「月に1回程度、問題時のみ確認」は25%にとどまり、「ほとんど確認できていない」という回答が0%であったことから、GSCのクロールレポートがSEO運用において不可欠なツールとして広く認識され、最低でも月に一度はチェックされていることが分かります。

このことから、ウェブサイトの健全性を保つために、クロールエラーの迅速な特定と修正が重視されており、GSCをSEO管理の中心的なタスクとして組み込んでいる企業が多いと言えます。

特に公開直後の迅速な確認は、新規コンテンツのインデックス登録を確実に進めるための実践的な運用姿勢を反映しています。

クローラビリティにおいて、クロールバジェットを意識した対策は?

「クローラビリティにおいて、クロールバジェットを意識した対策は?」のアンケートに対して41人が回答した結果です。

【SEOアンケート調査】クローラビリティにおいて、クロールバジェットを意識した対策は?#クローラビリティ #SEO #ディーボのSEOラボ

— ディーボのSEOラボ@SEO対策 (@seolabo85) October 20, 2025

この調査結果から、回答者の41.5%が「クロールバジェットは意識していない」と回答し、最多となりました。

これは、約半数のサイト運営者が、クロールされる量や頻度を制御し、重要なページへのクロールを優先させるという効率的なSEO戦略をまだ十分に導入できていない現状を示しています。

一方、「強く意識し低品質ページ等をブロック」している層が29.3%、「意識するが対策は限定的」な層が26.8%と、合わせて約56%が何らかの形でクロールバジェットを意識しており、特に大規模サイトやコンテンツ量の多いサイトでは、重要な課題として認識されています。

このことから、クロールバジェットの最適化は、一部の積極的なSEO担当者によって実行されているものの、ウェブサイト運営者全体では意識が低い、あるいは対策が後回しにされている傾向にあることがわかります。

今後、コンテンツ増加に伴うクロール効率の低下を防ぐため、低品質コンテンツの整理やrobots.txtによる制御といったバジェット対策の重要性はさらに高まると言えます。

新しい重要なコンテンツを公開した際、Googleサーチコンソールでクロールをリクエストしていますか?

「新しい重要なコンテンツを公開した際、Googleサーチコンソールでクロールをリクエストしていますか?」のアンケートに対して51人が回答した結果です。

【SEOアンケート調査】新しい重要なコンテンツを公開した際、Googleサーチコンソールでクロールをリクエストしていますか?#クローラビリティ #SEO #ディーボのSEOラボ

— ディーボのSEOラボ@SEO対策 (@seolabo85) October 21, 2025

この調査結果から、回答者の52.9%が「毎回必ずリクエストしている」と回答し、過半数に達しました。

これは、新規コンテンツの早期インデックス登録と検索結果への露出を確実にするため、GSCの「URL検査」ツールがSEOの実践的な必須プロセスとして定着していることを示しています。

また、「重要なページや緊急時のみリクエスト」している層が21.6%おり、約4分の3のサイト運営者が意図的にクロールをコントロールしようとしています。

この背景には、クローラーの自動巡回を待つことによる機会損失を防ぐという強い意識があると言えます。

一方で、「リクエストせず自動クロールを待つ」層が19.6%存在し、「方法を知らない・未実施」も5.9%いることから、全てのサイト運営者がこの迅速なインデックス施策を取り入れているわけではありません。

このことから、新しいコンテンツの公開と同時にGSCでクロールを促すことが、現代のSEOにおいて極めて重要度の高い初動施策として認識されていると結論づけられます。

クローラビリティにおいて、サイト内の最も深いページ(トップページからクリックで辿る階層)は、平均してどの程度の深さになっていますか?

「クローラビリティにおいて、サイト内の最も深いページ(トップページからクリックで辿る階層)は、平均してどの程度の深さになっていますか?」のアンケートに対して32人が回答した結果です。

【SEOアンケート調査】クローラビリティにおいて、サイト内の最も深いページ(トップページからクリックで辿る階層)は、平均してどの程度の深さになっていますか?#クローラビリティ #SEO #ディーボのSEOラボ

— ディーボのSEOラボ@SEO対策 (@seolabo85) October 22, 2025

この調査結果から、回答者の59.4%が「3クリック以内」と回答し、過半数を大きく超えました。

これは、多くのサイト運営者が、クローラビリティとユーザーエクスペリエンスの観点から、重要なコンテンツへのアクセスを浅い階層に保つことを強く意識していることを示しています。

一方、「4〜5クリック程度」が21.9%、「6クリック以上」が9.4%と、約3割のサイトでコンテンツが比較的深い階層に存在しています。

特に「6クリック以上」のサイトは、クローラビリティの課題を抱える可能性があり、クロール漏れや評価の分散につながりかねません。

このことから、「3クリックルール」に代表されるように、サイトの階層構造の最適化が基本的なクローラビリティ対策として広く実践されていることがわかります。

深い階層のサイトは、内部リンク構造の見直しやパンくずリストの実装など、さらなる改善を通じてクロール効率を向上させる必要があります。

クローラビリティの課題として、あなたのサイトで最も深刻だと考えている技術的要因は?

「クローラビリティの課題として、あなたのサイトで最も深刻だと考えている技術的要因は?」のアンケートに対して25人が回答した結果です。

【SEOアンケート調査】クローラビリティの課題として、あなたのサイトで最も深刻だと考えている技術的要因は?#クローラビリティ #SEO #ディーボのSEOラボ

— ディーボのSEOラボ@SEO対策 (@seolabo85) October 23, 2025

この調査結果から、回答者の36%が「JavaScriptのレンダリング問題」を最も深刻な課題として挙げ、最多となりました。

これは、現代のウェブサイト構築においてJavaScriptの使用が増加する一方で、Googlebotが完全にレンダリングできないことによるインデックス登録の遅延や失敗が、多くのサイトで重大な懸念事項となっていることを示唆しています。

次に深刻な課題として挙げられたのは「リンク切れの多さや、ページ間のリンク構造の不備」(32%)です。

これは、サイト内部のナビゲーションの不備が、クロールの妨げやページの評価分散に直結するという、基本的なクローラビリティの課題が依然として解決されていないことを示しています。

このことから、サイト運営者は、モダンな技術(JavaScript)がもたらす技術的な課題と、基本的なサイト構造(内部リンク)の両面において、クローラビリティの課題を抱えていると言えます。

特にJavaScriptのレンダリング問題は、高度な技術的解決が求められる、現代のSEOにおける最重要課題の一つとして浮上していることがわかります。

リンク切れ(404エラー)が発生した場合、クローラビリティの観点からどのように対応していますか?

「リンク切れ(404エラー)が発生した場合、クローラビリティの観点からどのように対応していますか?」のアンケートに対して32人が回答した結果です。

【SEOアンケート調査】リンク切れ(404エラー)が発生した場合、クローラビリティの観点からどのように対応していますか?#クローラビリティ #SEO #ディーボのSEOラボ

— ディーボのSEOラボ@SEO対策 (@seolabo85) October 24, 2025

この調査結果から、回答者の43.8%が「定期的に検出し、リンク元を修正するかページを復活」させると回答し、最も主要な対策として認識されていることが分かりました。

これは、内部リンクの健全性を保つことがクローラビリティの基本であり、エラーを根本から解消しようとする意識が高いことを示しています。

次に、「関連性の高いページにリダイレクト設定(301など)」が21.9%で続き、ページが移動・統合された際の評価の引き継ぎとユーザーの利便性を重視した対策も行われています。

この二つの積極的な対応策を合わせると約65%となり、多くの企業がリンク切れを重要なクローラビリティ課題として対処しています。

一方で、「リンク切れの検出自体を定期的に行っていない」(18.8%)や「404ページを表示するだけ」(15.6%)の層も合計で3割以上おり、基本的なエラー管理が不十分なサイトも存在します。

このことから、クローラビリティを最適化するためには、リンク切れの早期発見と、リンク元の修正または適切な301リダイレクトによる評価の維持が重要であると結論づけられます。

「クローラビリティ」に関するSEOアンケート調査結果から言えること

「クローラビリティ」に関するSEOアンケート調査結果から言えることとして、多くのサイト運営者がリンク切れ対策(リンク元修正・ページ復活: 43.8%)や、新しいコンテンツのクロールリクエスト(毎回必須: 52.9%)を積極的に行っていることがわかります。

また、XMLサイトマップの自動生成・更新(73%)も進んでおり、基本的な技術設定を重視している傾向が見られます。

一方で、クローラビリティの最大の課題として内部リンクの構造不備やリンク切れの多さ(32%)が挙げられており、実際、最も注力している施策も内部リンク最適化(48.1%)です。

また、クロールバジェットを意識した対策は41.5%が「意識していない」と回答しており、優先度が低い傾向があります。

全体として、内部リンク最適化の注力を継続しつつ、次に深刻な課題であるJavaScriptレンダリング問題(36%)への対応を強化することが重要です。

また、多くのサイトが深く意識していないクロールバジェットについても、低品質ページのブロックなど、より戦略的な対策を検討する余地があります。

「クローラビリティ」に関するSEOアンケート調査概要

「クローラビリティ」に関するSEOアンケート調査は、ディーボのSEOラボX公式アカウントの投票機能を使って2025年10月14日~24日の期間に行いました。この期間に集計した総数325人のユーザー様の回答を調査結果として、本ページのコンテンツに採用してます。

- 調査期間: 2025年10月14日~24日

- 調査対象地域: 全国

- 調査機関: 株式会社ディーボ

- 調査方法: オンラインアンケート調査(ディーボのSEOラボX公式アカウントの投票機能を使って調査)

- 調査人数: 325名

- 調査対象: SEO業務に従事する男女

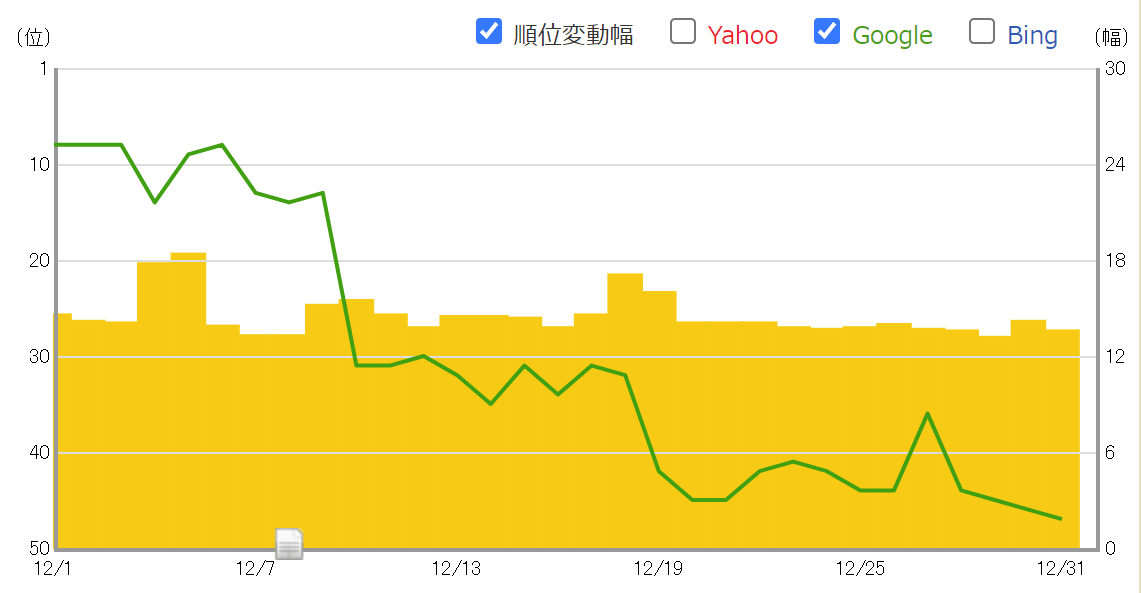

SEO対策しても検索順位が上がらない…なぜ?

SEO対策しても検索順位が上がらない…なぜ?

検索順位が上がらない理由は、SEO対策の質が低いからです。

例えば、ユーザーの検索意図を無視したり、関連性の低いコンテンツを増やす、内部リンクの最適化など疎かにします。

この場合、SEO対策の質が下がります。

そうなれば、ページやサイト自体の品質が上がらないので、Googleに評価されづらくなります。

結果、検索順位が上がらないというわけです。

こうした悪い状況を回避する為に、サイトの欠点を調査して上位化に必要な対策をご案内します(無料)。

検索順位を上げたり、検索流入を増やすにはSEOが重要!