【今週のSEO最新ニュース】2026/2/7~2/13のSEO最新情報11個!各要点をわかりやすく紹介

2026年2月7日~2月13日の間に公開されたSEOに関する最新ニュースを11個、ディーボのSEOラボX公式アカウントでポスト(投稿)しました。

これらのポストの要点をそれぞれまとめて、初心者にもわかりやすくSEO最新情報を紹介したいと思います。

- Google、Discoverガイドラインを更新。「クリックベイト」禁止を明文化し、ページ体験の重要性も追加されました

- クローラーの制限値を再定義。GooglebotはHTMLを2MB、PDFはそれ以上と柔軟に設定

- 2026年2月10日付近のGoogleアップデートによる検索への影響が複数報告されてる

- AIは構造化データを「特別なコード」ではなく、単なる「ページ上のテキスト」として処理しています

- ページ末尾の文章を「引用検索」するのが最善。データ容量を気にするより実効性を確認すべき

- AI版Wikipedia「Grokipedia」の露出が急落。Google検索やChatGPTでの引用も減少

- AIはページ下部の情報も引用します。配置場所より「見出し構造」の正しさが重要です

- サイトの「年数」より「価値」が重要。新しいサイトでも戦略次第で古い競合を追い抜くことは可能です

- ブラウザで隠れた「HTTP版」の放置が原因。サイト名やファビコンが誤表示される問題に注意

- 週8,000万人がReddit検索を利用中。AI回答の統合で「検索の完結」を目指すプラットフォームへ

- Bing Webmaster Toolsに「AI分析機能」が登場。AI回答での引用数や検索語句が可視化されます

Google、Discoverガイドラインを更新。「クリックベイト」禁止を明文化し、ページ体験の重要性も追加されました

Googleは2026年2月のDiscoverコアアップデートに合わせ、掲載ガイドラインを大幅に改訂しました。今回の修正では「クリックベイト(釣り記事)」という用語を初めて明文化し、読者の好奇心や怒りを不当に煽る扇情的な手法を厳格に禁じています。さらに「優れたページ体験の提供」という項目を新たに追加し、読み込み速度やモバイルフレンドリーといった操作性がDiscoverの評価に直結することを明確に示しました。

具体的には、タイトルの推奨事項が「内容の核心を突くこと」と「クリックベイトを避けること」の二点に分離され、より誠実な情報発信が求められるようになっています。これは現在進行中のアップデートが掲げる「地域性の重視」や「専門性の高い独自コンテンツの優先」という方針を文書化したものです。サイト運営者は単なる流入獲得だけでなく、記事を開いた後のユーザー体験まで含めた総合的な品質向上が不可欠となります。

結論として、GoogleはDiscoverを「信頼できる高品質な情報のプラットフォーム」へと進化させようとしています。2026年以降、過度な煽りタイトルで短期的な成果を狙う手法は通用しなくなり、ブランドの信頼性と快適な閲覧環境の構築こそが、継続的な露出を勝ち取る唯一の道となるでしょう。まずは自サイトの過去記事が新基準に抵触していないか点検し、タイトルと内容の整合性を再確認するとともに、ページ体験の最適化を急ぐべき時期と言えます。

Google、Discoverガイドラインを更新。「クリックベイト」禁止を明文化し、ページ体験の重要性も追加されました。#Discoverコアアップデート #Googleアップデート #SEOhttps://t.co/DHDcezhfFD

— ディーボのSEOラボ@SEO対策 (@seolabo85) February 9, 2026

※2026年2月のDiscoverコアアップデートに伴い、Googleは「Google…

クローラーの制限値を再定義。GooglebotはHTMLを2MB、PDFはそれ以上と柔軟に設定

Googleは、検索クローラーのファイルサイズ制限に関するドキュメントを再更新し、混乱を招いていた仕様を明確に定義しました。基本ルールとして、Googleの全クローラーはデフォルトでファイルの先頭15MBまでを読み込みますが、Google検索専用のGooglebotには個別の制限が適用されます。具体的には、HTML等のテキストベースのファイルは2MBまで、PDFは最大64MBまでがインデックスの対象となります。この数値を超えたコンテンツは無視されるため、巨大なファイルを持つサイトは注意が必要です。

今回の更新は動作の変更ではなく、あくまでドキュメントの整理と透明化を目的としたものです。Googleのインフラは検索だけでなく、ShoppingやGeminiなど多岐にわたる製品で共有されており、それぞれの用途に応じた制限が設けられています。HTMLで2MBを超えるページは稀ですが、不必要なコードが肥大化している場合、重要な情報が読み飛ばされるリスクがあります。SEO担当者は、主要なコンテンツが確実に2MBの範囲内に収まっているか、 uncompressed(非圧縮)の状態で確認することが求められます。

結論として、今回の明文化は技術的なトラブルシューティングを容易にするための指針となります。制限を超えると、ページの後半にある内部リンクや構造化データが認識されない可能性があるため、効率的なコード構造の維持が重要です。2026年以降、Googleはクローラーごとの詳細な仕様をさらに公開していく方針であり、運営者は自サイトのファイルサイズを定期的にモニタリングすべきでしょう。特にPDFを多用するサイトでは、64MBという上限を意識したデータ管理が、インデックス登録の確実性を高める鍵となります。

クローラーの制限値を再定義。GooglebotはHTMLを2MB、PDFはそれ以上と柔軟に設定。#クローラー #ファイルサイズ #SEOhttps://t.co/yqc6iWlada

— ディーボのSEOラボ@SEO対策 (@seolabo85) February 12, 2026

※Googleは、今月初めに行ったクローラーのファイルサイズ制限に関するドキュメントを再更新し、混乱を招いていた箇所を明確化しました。

1.…

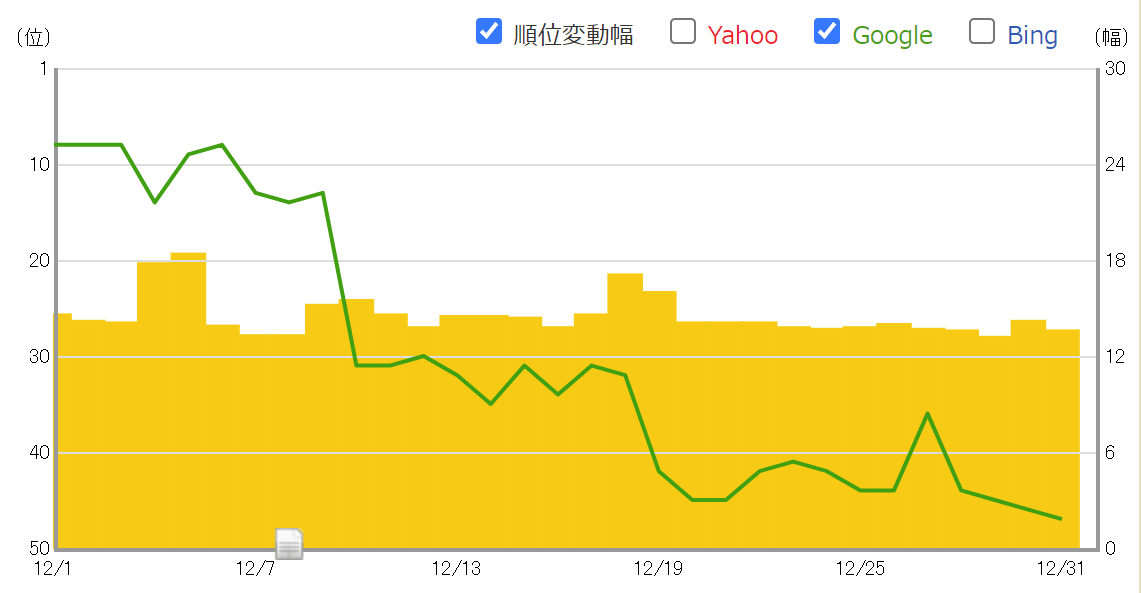

2026年2月10日付近のGoogleアップデートによる検索への影響が複数報告されてる

2026年2月10日前後、Google検索では公式発表のない激しい順位変動が観測され、多くのサイト運営者が混乱に陥っています。2月初旬のDiscoverアップデートの余波が続く中で発生した今回の変動は、かつての「Googleダンス」を彷彿とさせる予測不可能な動きが特徴です。一部ではDiscoverの流入が安定し始めたとの報告もありますが、全体的なランキングの乱高下は収まっておらず、システムの不安定さを指摘する声が相次いでいます。

現場からはトラフィックが急激に減少し、流入のほとんどがボットや無反応なユーザーに置き換わったという深刻な悲鳴が上がっています。数日で成果が消滅するほどの激しい下落に、長年SEOに携わる専門家からも「希望を失いかけている」といった極めて悲観的なコメントが寄せられました。変動は特定の分野に限定されず広範囲に及んでおり、インデックスの遅延や検索結果の不一致など、技術的な不具合を疑う意見も出始めています。

結論として、現在はアルゴリズムの大幅な再調整が行われている最中であり、安易なサイト修正はリスクが高い状況です。Googleは沈黙を守っていますが、計測ツールの数値は極めて高いボラティリティを示し続けており、事態の長期化が予想されます。運営者は一時的な数字の変動に一喜一憂せず、まずはデータの安定を待つとともに、自サイトの品質が最新のガイドラインに合致しているかを冷静に見極めるべき時期と言えるでしょう。

2026年2月10日付近のGoogleアップデートによる検索への影響が複数報告されてる。#Googleアップデート #SEO #SEO対策https://t.co/ulIittSthI…

— ディーボのSEOラボ@SEO対策 (@seolabo85) February 12, 2026

AIは構造化データを「特別なコード」ではなく、単なる「ページ上のテキスト」として処理しています

最新の検証により、ChatGPTやPerplexityなどのAIエンジンは、構造化データを特殊なコードではなく「ページ上のテキスト」として処理していることが判明しました。SEO専門家が架空の住所を無効な形式のスキーマ内のみに記載したところ、AIは技術的な不備を無視して情報を正確に抽出しました。これはAIがコードの正当性よりも、記述された内容そのものを情報の断片として柔軟に解釈していることを示唆しています。

この結果から、構造化データが従来の検索エンジン同様に有用である一方、生成エンジン最適化における「魔法の処方箋」ではないことも浮き彫りになりました。AI対策の本質は、特定のコード形式に固執することではなく、AIが拾いやすい明確な情報をページ内に配置することにあります。技術的なバリデーションを通過させること以上に、人間とAIの両方が理解できる一貫した情報をサイト全体に含めることが重要です。

結論として、AI時代のデータ提供は形式の正確性よりも「情報の視認性」が鍵となります。構造化データは引き続き活用すべきですが、それだけに頼らず、重要な事実は本文中にも分かりやすく記載する二段構えの対策が推奨されます。2026年の戦略としては、AIの柔軟な抽出能力を逆手に取り、あらゆる記述箇所を通じて自社の正確な情報をAIの知識源へと送り込む包括的なアプローチが求められるでしょう。

AIは構造化データを「特別なコード」ではなく、単なる「ページ上のテキスト」として処理しています。#構造化データ #AIエンジン #LLM https://t.co/GzrdUVUnIL…

— ディーボのSEOラボ@SEO対策 (@seolabo85) February 9, 2026

ページ末尾の文章を「引用検索」するのが最善。データ容量を気にするより実効性を確認すべき

Googleのジョン・ミューラー氏は、長いページが最後までインデックスされているかを確認する最も実用的な方法は、ページ末尾の一文を「引用符」で囲んで検索することだと述べました。近年議論されている2MBや15MBといったファイルサイズ制限を過度に心配する必要はありません。一般的なHTMLが制限を超えることは極めて稀であり、バイト数を細かく計算するよりも、実際の検索結果でコンテンツの網羅性を確認する方が確実で有益です。

記事を分割すべきか長文のままにすべきかという問いに対し、同氏はクローラーの制限ではなくユーザーの意図に基づいて判断すべきだと強調しています。詳細な情報を求める層には網羅的な記事が好まれ、特定の一節を評価するパッセージランキング機能によって長文でも適切に順位付けされるからです。SEO担当者は技術的な数値に固執するのではなく、コンテンツが読者の課題を解決し、満足度を高めているかに注力すべきです。

結論として、2026年のSEOにおいても「ユーザーにとっての有益性」という本質は変わりません。ページが最後まで読み取られているか不安な場合は、末尾の文章をGoogleの検索窓に放り込んで、実効性を即座に判断しましょう。サイズ制限を気にして内容を削るよりも、関連性が高く信頼できる情報を届ける姿勢こそが、AI検索時代においても安定した評価を獲得するための唯一の正攻法となります。

ページ末尾の文章を「引用検索」するのが最善。データ容量を気にするより実効性を確認すべき。#長いページ #インデックス #SEOhttps://t.co/jSlx8sH0K6…

— ディーボのSEOラボ@SEO対策 (@seolabo85) February 9, 2026

AI版Wikipedia「Grokipedia」の露出が急落。Google検索やChatGPTでの引用も減少

AI生成コンテンツによる百科事典サイト「Grokipedia」が、2026年2月に入りGoogle検索や主要AIエンジンで急速に可視性を失っています。1月にはインデックス数と順位が爆発的に上昇し注目を集めましたが、最新データでは検索可視性が重く急激に下落していることが判明しました。ログインなしのGoogle検索では、本来の公式サイトであるGrokipediaよりも従来のWikipediaが上位に表示される「順位逆転」も確認されています。

この下落傾向はオーガニック検索のみならず、Googleの「AI Mode」や「AI Overviews」、さらに「ChatGPT」といった対話型AIの引用ソースにも波及しています。1月下旬からこれらのAIが回答内でGrokipediaを推奨する頻度が目に見えて減少しました。専門家はこれを直近のアルゴリズム変動による影響と見ており、AIで大量生成された情報の信頼性や独創性に対し、Googleが評価基準を厳格化した可能性を指摘しています。

結論として、一時は「AI検索時代の新勢力」と目されたGrokipediaも、現在は低品質な自動生成コンテンツとして各エンジンから評価を見直されている段階にあります。これが一時的な調整か永続的な排除かは不明ですが、AI時代のSEOにおいても「人間による監修」や「情報の正確性」といった不変の価値が問われています。単なる情報のパッケージングではなく、AIの知識源として選ばれ続けるための「真の信頼性」の構築が改めて重要視されるでしょう。

AI版Wikipedia「Grokipedia」の露出が急落。Google検索やChatGPTでの引用も減少。#AI生成コンテンツ #AI大量生成 #SEOhttps://t.co/z1FiAPTfnU…

— ディーボのSEOラボ@SEO対策 (@seolabo85) February 12, 2026

AIはページ下部の情報も引用します。配置場所より「見出し構造」の正しさが重要です

ソルト・エージェンシーが2,300件以上の引用URLを調査した結果、Googleの「AI Mode」は情報の掲載位置を重視していないことが判明しました。従来、重要な情報はファーストビュー(画面上部)に配置すべきとされてきましたが、AIはページの下部数千ピクセルに位置する情報も正確に拾い上げています。旅行やSaaSなど各分野の分析において、コンテンツのピクセル深度と引用される確率に相関関係はなく、配置による有利・不利は存在しません。

AIが情報を抽出する際、最も重要な鍵となるのは「見出し構造」の正しさです。調査では、適切な小見出し(h2やh3)と、その直後に続く簡潔な回答文がセットで引用されるパターンが頻繁に確認されました。Googleはページ全体を断片化して解析しており、見出しをナビゲーションとして活用しながら関連セクションを特定しています。そのため、レイアウトの美しさよりも、論理的で整理された文章構造を維持することの方が、AIによる視認性向上に直結します。

結論として、AI検索対策のために情報をページ上部へ無理に詰め込む必要はありません。「AIに好まれる魔法のテンプレート」を追い求めるのではなく、SEOの基本に立ち返り、ユーザーの疑問へ誠実に応える高品質なコンテンツを論理的に構成すべきです。2026年以降は、AIが情報を理解しやすいよう適切に構造化されたページこそが、検索結果の深い場所からでも「信頼できるソース」として選ばれ続けることになるでしょう。

AIはページ下部の情報も引用します。配置場所より「見出し構造」の正しさが重要です。#AIモード #見出し構造 #SEOhttps://t.co/EFUYljqfij

— ディーボのSEOラボ@SEO対策 (@seolabo85) February 10, 2026

※ソルト・エージェンシーが2,300件以上の引用URLを調査した結果、Googleの「AI…

サイトの「年数」より「価値」が重要。新しいサイトでも戦略次第で古い競合を追い抜くことは可能です

Googleのジョン・ミューラー氏は、ドメインの「年数」そのものは検索順位を決定する直接的な要因ではないと明言しました。Redditでの「1年目のサイトが4年目の競合に勝てるか」という問いに対し、同氏は「サイトが年を取ることは避けられないが、価値ある存在になることは努力で勝ち取るものだ」と回答しています。4年間の歴史があっても改善のないサイトより、1年間で強固なユーザー基盤を築いた新しいサイトの方が高く評価される可能性があります。

被リンク数やドメインスコアといった表面的な指標の比較に固執しても、長年信頼を積み上げてきた競合を追い抜くことは困難です。ミューラー氏は、競合がその期間にどのような成果を出してきたのか、あるいは単に時間を浪費してきたのかを見極めることが重要だと助言しています。単なるSEOのテクニックによる微調整ではなく、ビジネスとしての実体的な価値の差を分析し、後発ならではの独自の強みを打ち出すことが成功への近道となります。

結論として、2026年のSEOにおいても「何を積み上げたか」という本質的な価値が問われます。ドメイン年齢という不可逆な要素に悩むよりも、マーケティングや機能性、ユーザー体験といった戦略的な視点からサイトを強化すべきです。技術的な最適化は前提条件に過ぎず、競合にはない独自の価値を提供し続けることこそが、先行するサイトとの壁を壊し、検索結果やAIの推奨リストにおいて確固たる地位を築くための唯一の手段となるでしょう。

サイトの「年数」より「価値」が重要。新しいサイトでも戦略次第で古い競合を追い抜くことは可能です。#ドメイン年齢 #SEO #SEO対策https://t.co/5PhB9fzXsf…

— ディーボのSEOラボ@SEO対策 (@seolabo85) February 10, 2026

ブラウザで隠れた「HTTP版」の放置が原因。サイト名やファビコンが誤表示される問題に注意

Googleのジョン・ミューラー氏は、HTTPS化されたサイトでもサーバーに残った古い「HTTP版」が、検索結果のサイト名やファビコンの誤表示を招く恐れがあると警告しました。現代のブラウザはHTTPをHTTPSへ自動転送するため管理者は放置に気づきにくいですが、Googlebotは自動変換せずHTTP版を直接読み取ることがあります。この時、HTTP版にサーバーの初期ページ等が残っていると、Googleはそちらの誤った情報を優先してしまいます。

Googleはサイト名やファビコンを決定する際、ホームページ内の構造化データやタイトルタグを参照するため、不完全なHTTP版の存在は表示の混乱を招く直接的な原因となります。この問題を確認する手段として、同氏はコマンドラインのcurlを用いた生のレスポンス確認や、Search ConsoleのURL検査ツールによるレンダリング結果の検証を推奨しています。ブラウザを介さない「Googleの視点」で自サイトを確認することが、潜在的なエラーの発見には不可欠です。

結論として、HTTPSへの移行が完了したと過信せず、目に見えないHTTP版の「ゴーストページ」を完全に排除することが重要です。サーバーレベルでHTTPからHTTPSへの適切な301リダイレクトを設定し、すべてのリクエストを確実に正規のページへ誘導するように徹底してください。2026年の検索環境においても、こうした基礎的な技術基盤の不備がブランドの視認性を損なう一因となるため、サイト名が正しく表示されない際はまず通信設定を疑うべきでしょう。

ブラウザで隠れた「HTTP版」の放置が原因。サイト名やファビコンが誤表示される問題に注意。#http #https #SEOhttps://t.co/uQjDS7nFnk…

— ディーボのSEOラボ@SEO対策 (@seolabo85) February 13, 2026

週8,000万人がReddit検索を利用中。AI回答の統合で「検索の完結」を目指すプラットフォームへ

Redditの2025年第4四半期決算により、同プラットフォームが強力な検索目的地へと進化している実態が明らかになりました。週間の検索利用者数は前年の6,000万人から8,000万人へと急増し、Google等の外部エンジンを介さずReddit内で直接情報を探す行動が定着しています。特にAI回答機能「Reddit Answers」の利用数は、1年前の年間100万件から直近の四半期だけで1,500万件へと爆発的な成長を遂げました。

Redditが掲げる目標は、調べ物の開始から意思決定までをサイト内で「完結」させる検索エンジンの構築です。購買相談や実体験を求める複雑な質問に対し、AIがコミュニティの膨大な議論を要約して提示することで、ユーザーの離脱を防ぎその場での決断を促しています。2026年現在、検索バーをホーム画面上部に常駐させる新レイアウトのテストも進行しており、情報の入り口としての利便性をさらに高めています。

結論として、Redditはもはや単なる掲示板ではなく、消費者の購買行動に強い影響力を持つ巨大な検索プラットフォームへと変貌しました。同社のコンテンツは外部のAIエンジンでも最も引用されるソースの一つとなっており、ネット上の情報の信頼性を担保する重要な役割を担っています。マーケターにとってReddit内での視認性確保は、Google対策と同様に不可欠な戦略であり、人間味のある議論の中へブランドを浸透させる重要性が増しています。

週8,000万人がReddit検索を利用中。AI回答の統合で「検索の完結」を目指すプラットフォームへ。#reddit #掲示板サイト #SEOhttps://t.co/WmGFPak10u

— ディーボのSEOラボ@SEO対策 (@seolabo85) February 10, 2026

※Redditの2025年第4四半期決算発表に基づき、同プラットフォームが強力な「検索目的地」へと進化している現状を解説した記事です。

1.…

Bing Webmaster Toolsに「AI分析機能」が登場。AI回答での引用数や検索語句が可視化されます

Microsoftは、Bing Webmaster Toolsに「AIパフォーマンス・ダッシュボード」を新たに導入しました。これにより、自サイトのコンテンツがCopilotなどのAI回答でどのように活用されているかを、具体的な数値で把握できるようになります。レポートでは総引用数や平均引用ページ数に加え、AIが回答生成時に使用した検索語句である「グラウンディング・クエリ」といった、GEO対策に不可欠な指標が提供されます。

GoogleのSearch ConsoleがAI回答を通常の検索データに含めて表示するのに対し、BingはAI引用専用の独立したレポートを業界で初めて公開しました。特定のURLがどの程度頻繁に引用されているかを詳細に分析できるため、推測に頼らない精度の高い「生成エンジン最適化」が可能となります。現在はパブリックプレビュー版として公開されており、データの蓄積に合わせてさらなる指標の拡充や洗練が計画されています。

結論として、この機能の登場はサイト運営者が「AIに情報を引用されているか」という不透明な状況を脱する画期的な一歩となります。データに基づいたAIフレンドリーなコンテンツ制作が可能になり、SEO担当者にとってBing Webmaster Toolsの重要性が改めて高まっています。2026年以降、AIによる要約が検索の主流となる中で、引用の可視化は競合サイトに差をつけ、ブランドの信頼性を確立するための強力な武器となるでしょう。

Bing Webmaster Toolsに「AI分析機能」が登場。AI回答での引用数や検索語句が可視化されます。#Bingウェブマスターツール #SEO #GEOhttps://t.co/jCFP3c8Fk4

— ディーボのSEOラボ@SEO対策 (@seolabo85) February 10, 2026

※Microsoftは、Bing Webmaster…

SEO対策しても検索順位が上がらない…なぜ?

SEO対策しても検索順位が上がらない…なぜ?

検索順位が上がらない理由は、SEO対策の質が低いからです。

例えば、ユーザーの検索意図を無視したり、関連性の低いコンテンツを増やす、内部リンクの最適化など疎かにします。

この場合、SEO対策の質が下がります。

そうなれば、ページやサイト自体の品質が上がらないので、Googleに評価されづらくなります。

結果、検索順位が上がらないというわけです。

こうした悪い状況を回避する為に、サイトの欠点を調査して上位化に必要な対策をご案内します(無料)。

- « 前の記事

【今週のSEO最新ニュース】2026/1/31~2/6のSEO最新情報21個!各要点をわかりやすく紹介 - 次の記事 »

検索順位を上げたり、検索流入を増やすにはSEOが重要!